Geheime Dokumente: Facebook scheint Funktionen zu bieten und über der Sicherheit der Benutzer zu profitieren

Facebook, der 13-jährige Gigant mit 1,23 Milliarden aktiven Nutzern, erwirtschaftet einen Umsatz von über 8 Milliarden US-Dollar pro Quartal - 3 Milliarden US-Dollar davon sind Nettoeinkommen (z. B. Gewinn).

Bei so vielen Nutzern scheint Facebook die Sicherheit der Nutzer zu einem zweitrangigen Problem gemacht zu haben. Bis Anfang dieses Jahres beschäftigte Facebook nur 4.500 Mitarbeiter, um Inhalte zu überprüfen. Das klingt nach einer Menge Leute, bis Sie feststellen, dass diese 1,23 Milliarden aktiven Benutzer sich teilen Milliarden Täglich werden Millionen von Nutzerbeschwerden über Facebook-Inhalte eingereicht.

Hat Facebook ein ernstes Problem mit der Sicherheit der Nutzer? Eine gerade veröffentlichte Wächter Die Überprüfung geheimer interner Dokumente deutet darauf hin, dass das Problem außer Kontrolle geraten ist.

Facebook gab zu, dass es ein Problem gibt, als es sich Anfang dieses Jahres bereit erklärte, sein Überprüfungspersonal auf 7.500 zu verdoppeln, unter dem Vorwurf, dass das Unternehmen einfach nicht genug tut (oder sich vielleicht darum kümmert?), Wenn potenziell schädliche Inhalte über seine Plattform gehandelt werden . Sie verdoppeln Ihr Moderationspersonal nicht, wenn alles gut läuft.

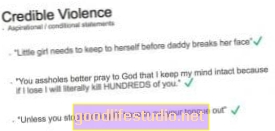

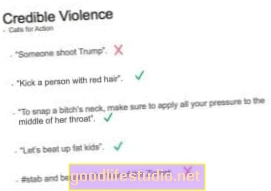

Jetzt, Der (britische) Wächter hat erstaunliche Details zu den Richtlinien für die Moderation von Inhalten auf Facebook veröffentlicht, die aus mehr als 100 geheimen internen Schulungshandbüchern und Dokumentationen stammen. Es ist ein wenig beunruhigend, dass all diese wichtigen Dinge nicht in einem einzigen Handbuch enthalten sind, das den Moderatoren von Facebook bei der Einstellung gegeben wird.Stattdessen scheint es sich um einen schrittweisen Ansatz für die Politik zu handeln, der zu widersprüchlichen Informationen, ungleichmäßiger Moderation und sehr geringer Zuverlässigkeit bei der tatsächlichen Funktionsweise der Moderationsrichtlinien in der realen Welt führt.

"Facebook kann die Kontrolle über seinen Inhalt nicht behalten", sagte eine Quelle. "Es ist zu groß geworden, zu schnell."

Viele Moderatoren sollen Bedenken hinsichtlich der Inkonsistenz und der Besonderheit einiger Richtlinien haben. Diejenigen, die sich mit sexuellen Inhalten befassen, gelten beispielsweise als die komplexesten und verwirrendsten.

Als nur ein winziges Beispiel dafür, wie viel Inhalt Facebook moderiert, heißt es in den Artikeln: „Ein Dokument besagt, dass Facebook wöchentlich mehr als 6,5 Millionen Berichte über potenziell gefälschte Konten überprüft - bekannt als FNRP (gefälschte, nicht reale Person).“ Und das ist nur für gefälschte Konten. Stellen Sie sich vor, wie viele Millionen weitere Berichte für den tatsächlichen Inhalt vorliegen.

Funktionen vor dem Gedanken

Bevor darüber nachgedacht wird, wie Benutzer eine neue Funktion nutzen (und missbrauchen) könnten, scheint Facebook es vorzuziehen, Inhalte einzuführen und nachträglich herauszufinden, wie sie moderiert werden können. Schauen Sie sich Facebook Live an, einen Video-Streaming-Dienst, mit dem Menschen Videos erstellen können, was gerade in ihrem Leben passiert. Wofür dachten sie, würden die Leute es irgendwann benutzen?

Dies zeigt einen konsequenten Mangel an Nachdenken über die Probleme und deren proaktive Lösung, bevor sie auftreten. Oder auf der Seite von "Hey, lass uns damit anfangen und sehen, was für ein Aufschrei es wird, bevor wir etwas dagegen unternehmen." (Alles natürlich im Namen der „Redefreiheit“, wobei die Tatsache ignoriert wird, dass Facebook eine globale Plattform ist.) 1

Wo habe ich diese Moderationsrichtlinie noch einmal platziert?

Und vielleicht alle in einem einzigen Handbuch? Die Moderatoren wissen also, wo sie suchen müssen, und müssen alle Richtlinien konsistent sein?

Selbstverletzende Videos sind in der Facebook-Welt vollkommen in Ordnung, da die Person "in Not" ist. Ist dies auch Tierquälerei (vielleicht weil das Tier in Not ist?). "Revenge Porn" ist auch in Ordnung, wenn der Moderator nicht bestätigen kann, dass beide Parteien nicht einverstanden sind (was meiner Meinung nach ziemlich schwierig sein könnte, dies rechtzeitig zu tun).

"Einige Fotos von nicht-sexuellem körperlichem Missbrauch und Mobbing von Kindern müssen nicht gelöscht oder" gehandelt "werden, es sei denn, es gibt ein sadistisches oder feierliches Element." Solange Sie Sadismus und Feiern aus Ihren gewalttätigen Bildern und Videos heraushalten, wird Facebook sie anscheinend zulassen.

In den Dokumenten heißt es: „Videos von gewaltsamen Todesfällen sind störend, können aber zur Bewusstseinsbildung beitragen. Für Videos denken wir, dass Minderjährige Schutz brauchen und Erwachsene eine Wahl brauchen. Wir markieren als "störende" Videos den gewaltsamen Tod von Menschen. " Es ist nicht klar, wo Selbstmordinhalte - wie Live-Videos oder Bedrohungen - in die Moderationsrichtlinien von Facebook fallen, aber es scheint zulässig zu sein.

Facebook muss die Sicherheit der Benutzer priorisieren

Einige haben eine strengere Regulierung von Facebook gefordert, da es der Gatekeeper all dieser Inhalte ist (ähnlich wie ein Fernsehsender der Gatekeeper von Inhalten in seinem Netzwerk ist):

In einem am 1. Mai veröffentlichten Bericht britischer Abgeordneter heißt es: „Die größten und reichsten Social-Media-Unternehmen sind schändlicherweise weit davon entfernt, ausreichende Maßnahmen zu ergreifen, um illegale oder gefährliche Inhalte zu bekämpfen, angemessene Community-Standards umzusetzen oder ihre Benutzer zu schützen.“

Es mag eine gute Idee sein, sich auf die Seite der „Redefreiheit“ zu stellen, insbesondere für ein amerikanisches Unternehmen. Soziale Netzwerke sind jedoch in erster Linie Online-Communities - sie ähneln nicht viel Zeitungen. Der Hauptzweck von Facebook ist es, Menschen miteinander zu verbinden. Daraus folgt, dass ihre Richtlinien diese Vielfalt besser widerspiegeln und auf die Sicherheit dieser Gemeinschaft ausgerichtet sind, als irgendeine Art von Mantra oder leerer Ideologie für die Veröffentlichung von Nachrichten.

Wir möchten, dass Facebook transparenter darüber wird, wie es täglich Millionen von Menschen und Inhalten moderiert. Wenn Sie diese Probleme besser beleuchten, können Sie auf Probleme hinweisen und Facebook die Möglichkeit geben, die Sicherheit seiner Community zu verbessern. Und wir möchten, dass Facebook viel mehr von seinem Einkommen investiert, um sicherzustellen, dass es über genügend Personal verfügt, um seine Plattform sicher zu halten. Für alle Benutzer.

Für weitere Informationen

Fußnoten:

- Oh, und beachten Sie, dass wenn Sie 100.000 weitere Follower auf Facebook haben, dies Sie in ihren Augen zu einer „öffentlichen Persönlichkeit“ macht - und nicht der Privatsphäre oder anderen Schutzmaßnahmen gewöhnlicher Menschen unterliegt. [↩]

.jpg)