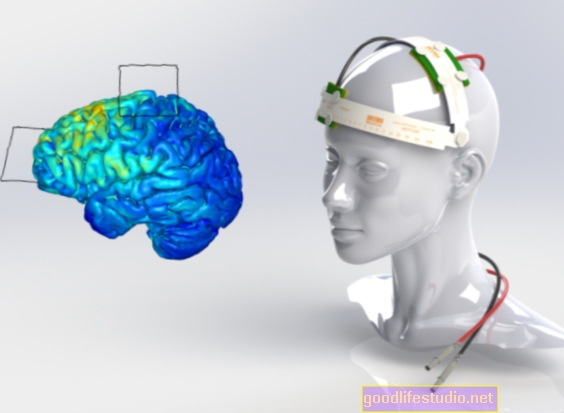

In der Entwicklung: Smartphones, die die Stimmung beurteilen können

Das Programm analysiert nicht, was eine Person sagt, sondern wie.

"Wir haben tatsächlich Aufnahmen von Schauspielern verwendet, die das Datum des Monats vorlesen - es ist wirklich egal, was sie sagen, es ist, wie sie es sagen, an dem wir interessiert sind", sagte Wendi Heinzelman, Ph.D., Professor der Elektro- und Computertechnik.

Das Programm analysiert 12 Sprachmerkmale wie Tonhöhe und Lautstärke, um eine von sechs Emotionen aus einer Tonaufnahme zu identifizieren. Forscher sagen, dass es eine Genauigkeit von 81 Prozent erreicht, eine signifikante Verbesserung gegenüber früheren Studien, die nur eine Genauigkeit von etwa 55 Prozent erreichten.

Die Forschung wurde bereits verwendet, um einen Prototyp einer App zu entwickeln, die entweder ein fröhliches oder ein trauriges Gesicht zeigt, nachdem sie die Stimme des Benutzers aufgezeichnet und analysiert hat. Es wurde von einem von Heinzelmans Doktoranden, Na Yang, während eines Sommerpraktikums bei Microsoft Research gebaut.

„Die Forschung steckt noch in den Anfängen“, räumte Heinzelman ein, „aber es ist leicht, sich eine komplexere App vorzustellen, die diese Technologie für alles verwenden kann, von der Anpassung der auf Ihrem Handy (Telefon) angezeigten Farben bis zur Wiedergabe von Musik, die Ihren Vorstellungen entspricht Ich fühle mich nach der Aufnahme Ihrer Stimme. "

Heinzelman und ihr Team arbeiten mit den Rochester-Psychologen Dr. Melissa Sturge-Apple und Patrick Davies, die derzeit die Interaktionen zwischen Teenagern und ihren Eltern untersuchen. "Eine zuverlässige Methode zur Kategorisierung von Emotionen könnte für unsere Forschung sehr nützlich sein", sagte Sturge-Apple. "Es würde bedeuten, dass ein Forscher nicht auf die Gespräche hören und die Emotionen verschiedener Menschen in verschiedenen Stadien manuell eingeben muss."

Den Forschern zufolge beginnt das Unterrichten eines Computers, Emotionen zu verstehen, damit, zu erkennen, wie Menschen dies tun.

"Sie könnten jemanden sprechen und denken hören:" Oh, er klingt wütend. "Aber was bringt Sie dazu, das zu denken?" sagte Sturge-Apple.

Sie erklärte, dass Emotionen die Art und Weise beeinflussen, wie Menschen sprechen, indem sie Lautstärke, Tonhöhe und sogar die Harmonischen ihrer Sprache verändern. "Wir achten nicht einzeln auf diese Funktionen, sondern lernen gerade, wie sich Wut anhört - insbesondere für Menschen, die wir kennen", fügte sie hinzu.

Damit ein Computer Emotionen kategorisieren kann, muss er mit messbaren Größen arbeiten. So stellten die Forscher 12 spezifische Merkmale in der Sprache fest, die in jeder Aufzeichnung in kurzen Intervallen gemessen wurden. Die Forscher kategorisierten dann jede der Aufzeichnungen und verwendeten sie, um dem Computerprogramm beizubringen, wie "traurig", "glücklich", "ängstlich", "angewidert" oder "neutral" klingt.

Das System analysierte dann neue Aufzeichnungen und versuchte festzustellen, ob die Stimme in der Aufzeichnung eine der bekannten Emotionen darstellte. Wenn das Computerprogramm nicht zwischen zwei oder mehr Emotionen entscheiden konnte, wurde diese Aufnahme einfach nicht klassifiziert.

"Wir möchten zuversichtlich sein, dass der Computer, wenn er glaubt, dass die aufgezeichnete Sprache eine bestimmte Emotion widerspiegelt, diese Emotion höchstwahrscheinlich darstellt", sagte Heinzelman.

Frühere Untersuchungen haben gezeigt, dass Emotionsklassifizierungssysteme stark sprecherabhängig sind, was bedeutet, dass sie viel besser funktionieren, wenn das System mit derselben Stimme trainiert wird, die es analysiert. "Dies ist nicht ideal für eine Situation, in der Sie einfach ein Experiment mit einer Gruppe von Menschen durchführen möchten, die sprechen und interagieren, wie die Eltern und Jugendlichen, mit denen wir arbeiten", sagte Sturge-Apple.

Die neuen Ergebnisse bestätigen diesen Befund. Wenn die sprachbasierte Emotionsklassifizierung für eine andere Stimme verwendet wird als die, die das System trainiert hat, sank die Genauigkeit von 81 Prozent auf etwa 30 Prozent. Die Forscher suchen nun nach Möglichkeiten, diesen Effekt zu minimieren, indem sie das System mit einer Stimme der gleichen Altersgruppe und des gleichen Geschlechts trainieren.

"Es sind noch Herausforderungen zu lösen, wenn wir dieses System in einer Umgebung einsetzen möchten, die einer realen Situation ähnelt, aber wir wissen, dass der von uns entwickelte Algorithmus effektiver ist als frühere Versuche", sagte Heinzelman.

Quelle: Universität von Rochester