Hören Sie sich den Cocktailparty-Effekt im Gehirn an

Einige Personen können sich trotz einer Umgebung, die die Stimme einer Person verdeckt, auf einen einzelnen Sprecher konzentrieren. Die Umgebung kann ein Klassenzimmer, eine Bar oder ein Sportereignis sein - die Fähigkeit ist nicht einzigartig und wurde von Psychologen als „Cocktailparty-Effekt“ beschrieben.

Eine neue Forschungsarbeit unter der Leitung eines Neurochirurgen der University of California in San Francisco und eines Postdoktoranden konzentrierte sich darauf, herauszufinden, wie selektives Hören im Gehirn funktioniert.

Edward Chang, M. D., und Nima Mesgarani, Ph.D., arbeiteten mit drei Patienten, die sich wegen schwerer Epilepsie einer Gehirnoperation unterzogen.

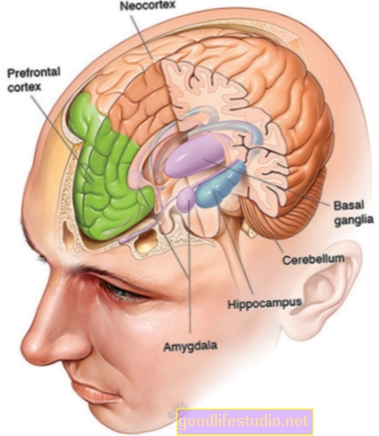

Ein Teil dieser Operation besteht darin, die Teile des Gehirns zu lokalisieren, die für die Deaktivierung von Anfällen verantwortlich sind. Bei dieser Übung wird die Aktivität des Gehirns über eine Woche abgebildet, wobei eine dünne Schicht mit bis zu 256 Elektroden unter dem Schädel auf der Außenfläche oder dem Kortex des Gehirns platziert wird. Die Elektroden zeichnen die Aktivität im Temporallappen auf - Heimat des auditorischen Kortex.

Laut Chang bot die Möglichkeit, intrakranielle Aufzeichnungen sicher aufzuzeichnen, einzigartige Möglichkeiten, um das grundlegende Wissen über die Funktionsweise des Gehirns zu erweitern.

"Die Kombination aus hochauflösenden Gehirnaufzeichnungen und leistungsstarken Dekodierungsalgorithmen öffnet ein Fenster in die subjektive Erfahrung des Geistes, die wir noch nie zuvor gesehen haben", sagte Chang.

In den Experimenten hörten die Patienten zwei gleichzeitig abgespielten Sprachproben zu, in denen verschiedene Phrasen von verschiedenen Sprechern gesprochen wurden. Sie wurden gebeten, die Wörter zu identifizieren, die sie von einem der beiden Sprecher gesprochen hatten.

Die Autoren wendeten dann neue Dekodierungsmethoden an, um zu „rekonstruieren“, was die Probanden aus der Analyse ihrer Gehirnaktivitätsmuster hörten.

Auffallenderweise stellten die Autoren fest, dass neuronale Reaktionen im auditorischen Kortex nur die des Zielsprechers widerspiegelten. Sie fanden heraus, dass ihr Decodierungsalgorithmus anhand dieser neuronalen Muster vorhersagen konnte, welcher Sprecher und sogar welche spezifischen Wörter das Subjekt hörte. Mit anderen Worten, sie konnten erkennen, wann die Aufmerksamkeit des Hörers auf einen anderen Sprecher gerichtet war.

"Der Algorithmus hat so gut funktioniert, dass wir nicht nur die richtigen Antworten vorhersagen konnten, sondern auch, wenn sie auf das falsche Wort geachtet haben", sagte Chang.

Die neuen Erkenntnisse zeigen, dass die Darstellung von Sprache im Kortex nicht nur die gesamte äußere akustische Umgebung widerspiegelt, sondern genau das, was wir wirklich hören wollen oder müssen.

Sie stellen einen großen Fortschritt beim Verständnis der Verarbeitung der Sprache durch das menschliche Gehirn dar und haben unmittelbare Auswirkungen auf die Untersuchung von Beeinträchtigungen während des Alterns, Aufmerksamkeitsdefizitstörungen, Autismus und Sprachlernstörungen.

Darüber hinaus sagt Chang, dass wir diese Technologie möglicherweise eines Tages für neuroprothetische Geräte verwenden können, um die Absichten und Gedanken gelähmter Patienten zu entschlüsseln, die nicht kommunizieren können.

Ein Verständnis darüber, wie unser Gehirn so verdrahtet ist, dass einige akustische Signale anderen vorgezogen werden, kann neue Ansätze zur Automatisierung und Verbesserung der Filterung von Tönen durch sprachaktivierte elektronische Schnittstellen fördern, um verbale Befehle richtig zu erkennen.

Die Methode, mit der sich das Gehirn so effektiv auf eine einzelne Stimme konzentrieren kann, ist für Unternehmen, die elektronische Geräte mit sprachaktiven Schnittstellen entwickeln, von großem Interesse.

Während die Spracherkennungstechnologien, die Schnittstellen wie Siri von Apple ermöglichen, in den letzten Jahren einen langen Weg zurückgelegt haben, sind sie bei weitem nicht so ausgefeilt wie das menschliche Sprachsystem. Zum Beispiel kann eine durchschnittliche Person in einen lauten Raum gehen und relativ leicht ein privates Gespräch führen - als ob alle anderen Stimmen im Raum stumm geschaltet wären.

Die Spracherkennung, sagte Mesgarani, ein Ingenieur mit einem Hintergrund in der automatischen Spracherkennungsforschung, "ist etwas, in dem Menschen bemerkenswert gut sind, aber es stellt sich heraus, dass die maschinelle Emulation dieser menschlichen Fähigkeit äußerst schwierig ist."

Der Forschungsartikel erscheint in der Zeitschrift Natur.

Quelle: Universität von Kalifornien, San Francisco (UCSF)