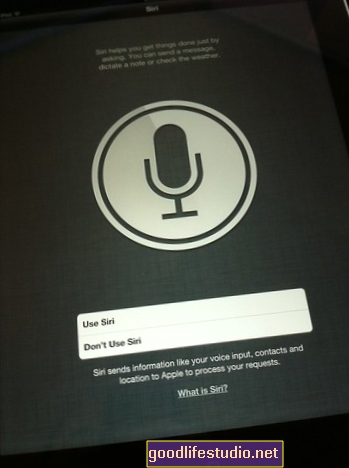

Apples Siri war immer noch fehlerhaft, wenn es um Selbstmord ging

Ich sagte ihr, ich wollte mich umbringen ... und ich wollte und brauchte Hilfe.

Und im Grunde sagte sie mir, dass ich kein Glück hatte. Egal wie ich meine (falschen) Selbstmordabsichten formulierte, Siri antwortete laut und deutlich: Sie konnte keine Selbstmordpräventionszentren finden.

Ab März dieses Jahres:

Ich: Ich möchte mich selbst erschießen.

Siri: Ich habe keine Selbstmordpräventionszentren gefunden.

Ich: Können Sie sich mehr Mühe geben, ein Selbstmordpräventionszentrum zu finden?

Siri: Ich konnte keine Selbstmordpräventionszentren finden.

Ich: Gibt es eine Telefonnummer, die ich anrufen kann, wenn ich mich umbringen will?

Siri: Ich konnte keine Selbstmordpräventionszentren finden.

Sie war nutzlos. Ich habe lange und intensiv versucht, mit mehreren Wörtern und Phrasen eine hilfreiche Ressource zu finden. Insbesondere habe ich versucht, Siri dazu zu bringen, mir eine Telefonnummer für eine nationale Selbstmord-Hotline - oder zumindest eine lokale Ressource - zur Verfügung zu stellen.

Siri hat mir ein paar Motorradhändler gefunden (warum? !!), aber nichts hindert mich daran, mich umzubringen. Hat sich also etwas geändert?

Hat Siri etwas Neues gelernt?

Apple hat im vergangenen Monat sein neues Betriebssystem veröffentlicht, daher habe ich beschlossen, Siri mit meinen für das Fernsehen hergestellten Selbstmordabsichten erneut zu testen. Dieses Mal habe ich mich für mein neues iPad und die frisch aktualisierte iOS 6-Software entschieden:

Wie Sie sehen, ist sie immer noch keine große Hilfe. Es sei denn, ich lebe im richtigen Zustand oder frage sie mit ganz bestimmten Kombinationen von Wörtern und Phrasen.

Lassen Sie uns diesmal etwas mehr untersuchen: Wessen Schuld ist das? Hat Apple etwas falsch gemacht?

Wer ist schuld? Siri oder die lokalen Suchwebsites?

Wenn Siri wirklich Schlüsselwörter im Zusammenhang mit Selbstmord aufgreift (wie z. B. „töten“ und „ich“ im selben Satz) und Unternehmen zurückgibt, die in der Kategorie „Selbstmordpräventionszentrum“ gekennzeichnet sind, dann diese Kategorie - je nachdem, welches Data Warehouse sie verwaltet - muss um psychiatrische Behandlungseinrichtungen, Psychologen und sogar Notaufnahmen erweitert werden. Es ist nicht in Ordnung, wenn jemand, der in New York Selbstmord begeht, eine positive Antwort auf die Frage erhält: "Gibt es ein Selbstmordpräventionszentrum in meiner Nähe?" während jemand in Pennsylvania nichts bekommt. Dort sind Ressourcen in Pennsylvania, aber der Suchalgorithmus von Siri ist fehlerhaft.

Ich habe drei Jahre im suchbasierten Online-Marketing gearbeitet. Aus meiner Erfahrung weiß ich Folgendes: Jedes Unternehmen fällt unter mindestens eine Überschrift.Um diesen Punkt zu veranschaulichen, lassen Sie uns einen Moment über das Abendessen sprechen.

Eines meiner Lieblingsrestaurants heißt Jasmine Thai und serviert in Williamsport, PA, sowohl thailändisches als auch chinesisches Essen. Ich habe dort letzte Woche gegessen.

Verzeichnis-Websites (wie yelp.com, Yellowpages.com oder Yellowbook.com) klassifizieren Unternehmen anhand ihrer Kategorie. Da Jasmine thailändisches Essen verkauft, fallen sie möglicherweise unter die Kategorie „Thailändische Restaurants“. Sie verkaufen jedoch auch chinesisches Essen, sodass es nicht ausreicht, sie einfach in einer Kategorie „Thailändische Restaurants“ zu kennzeichnen.

Denken Sie an die altmodischen Telefonbücher, die Sie wahrscheinlich nicht mehr verwenden. Es gibt eine Überschrift für fast alles, oder? Obwohl Jasmine thailändisches und chinesisches Essen verkauft, werden Sie es nicht finden, wenn die Verzeichnisfirma (in diesem Fall beispielsweise Yellowbook) sie nur unter "Thailändische Restaurants" auflistet, wenn Ihre Finger durch den Abschnitt "Chinesisches Essen" gehen.

Wenn wir dasselbe Konzept auf die Online-Suche anwenden, können wir davon ausgehen, dass eine Suche nach „chinesischen Restaurants“ Jasmine nicht hervorruft. Daher sollte ein Unternehmen in jeder relevanten Weise kategorisiert werden. Jasmin sollte als „thailändisches Restaurant“, „chinesisches Restaurant“, „Restaurant“ und, wenn sie Catering anbieten, als „Catering-Service“ eingestuft werden.

Mein Punkt: Je mehr Überschriften, desto besser. Es liefert relevantere Ergebnisse für den Verbraucher.

Wenn Sie etwas über die lokale Unternehmenssuche wissen, werden Sie leicht erkennen, dass dies eine ziemlich vereinfachte Methode ist, um die Komplexität zu erklären - aber lassen Sie mich einen Moment mit mir darüber sprechen.

Hier ist meine Theorie: Ich denke, der Deal mit dem "Suizidpräventionszentrum" kann auf die gleiche Weise erklärt werden. Ich vermute, es gibt da draußen eine Überschrift namens "Suizidpräventionszentren", aber zu wenige psychiatrische Einrichtungen klassifizieren sich unter dieser Überschrift - was dazu führt, dass Siri offensichtlich keine Ressourcen zur Suizidprävention gefunden hat.

Google gibt mir nicht gerade viel, wenn ich versuche zu untersuchen, aus welchem Datenpool Siri sucht, um Ergebnisse zurückzugeben. Aber ob es sich um Yelp, Yellowbook oder Google Places handelt, wir wissen, dass etwas nicht stimmt - und es liegt wahrscheinlich am hinteren Ende.

Lösungen für Siri und Selbstmord

Hier gibt es zwei mögliche Lösungen. Apple kann etwas tun, und Sie - oder der Manager Ihrer örtlichen psychiatrischen Einrichtung - können etwas tun.

1. Apple kann Siri aktualisieren, um aktuell eine breitere Suche durchzuführen, wenn sie Selbstmordattentate hört.

Selbstmordwörter und -phrasen scheinen derzeit eine Kategorie „Selbstmordpräventionszentrum“ zu sein. Es gibt aber noch viele andere Dienste, die es nicht gibt einzig und allein Suizidpräventionszentren - die Suizidberatung, Überweisungen und Hilfe anbieten.

Wenn Siri an dem geografischen Ort, von dem aus der Benutzer sucht, keine Suchergebnisse für "Suizidpräventionszentrum" abruft, sollte sie standardmäßig eine verwandte Kategorie wie "psychiatrische Einrichtungen" oder "Psychologen" oder "Depressionsberatung" verwenden. Dies würde die Wahrscheinlichkeit erheblich erhöhen, dass jeder, der Siri seine Selbstmordgedanken anvertraut, zumindest findet ETWAS Art der lokalen Ressource.

Ich bin mir auch sicher, dass Apple für das Programm Siri eine Möglichkeit hat, die lokalen Suchergebnisse für Selbstmordhinweise zu umgehen und eine Suche nach zu starten National Selbstmord-Hotlines. Es gibt keinen guten Grund für Siri, lokale Ergebnisse zu präsentieren, wenn der Benutzer einen Dienst anfordert, der nicht ortsabhängig ist.

2. Wenn Sie eine psychiatrische Einrichtung besitzen oder verwalten, die mit Selbstmördern zusammenarbeitet, aktualisieren Sie Ihre Überschriften auf lokalen Suchwebsites.

Suchen Sie selbst mit Schlüsselwörtern wie „Suizidpräventionszentrum“. Nicht nur bei Google, sondern auch auf spezialisierten lokalen Suchwebsites wie Yelp. Und Yellowbook. Und ZipLocal.

Wenn Ihr Unternehmen nicht zurückkehrt, wenden Sie sich an diese lokalen Suchunternehmen, um sie zu bitten, Ihren Eintrag zu aktualisieren, um genauere Überschriften wiederzugeben. Vielleicht ist Ihre Krisenberatungsstelle unter der Überschrift "Krisenberatung" aufgeführt - aber sollte sie nicht auch unter "Psychiatrische Dienste" aufgeführt sein? Und vielleicht "Psychologen"? Und "Selbstmordpräventionszentren"?

Holen Sie sich diese Überschriften hinzugefügt. Denken Sie an den Verbraucher - welche Worte würden Sie Geben Sie in der Regel Google ein, wenn Sie Ihr Unternehmen aufrufen möchten. Suchen Sie nach Überschriften, die diese Wörter widerspiegeln, und stellen Sie sicher, dass Sie unter ihnen aufgeführt sind.

Wenn Apple meine Bitte, den Algorithmus zu ändern, vernachlässigt (wahrscheinlich!), Zumindest Ihre eigene Aktionen könnten helfen. Wenn Siri Ihre örtlichen psychiatrischen Zentren als „Selbstmordpräventionszentren“ einstuft, kann dies dazu beitragen, dass sie aufgerufen werden, wenn jemand in Ihrer Gemeinde sie um Selbstmordressourcen bittet.

Immerhin ist die zuletzt Wir möchten Menschen, die sich selbstmordgefährdet fühlen, vermitteln, dass es nichts gibt, was ihnen helfen könnte. Richtig?

Und Siri macht immer noch genau das.